Marzo 15, 2023

Los modelos GPT (Generative Pre-trained Transformer) han estado fascinado al mundo de la inteligencia artificial. Con un rendimiento mejorado sobre las arquitecturas de redes neuronales y una escala sin precedentes, estos modelos de procesamiento de lenguaje han revolucionado la IA basada en el lenguaje natural. Solo hay que ver ChatGPT para llegar a esta conclusión.

Los modelos de lenguaje preentrenados por OpenAI, GPT-3 y el más que reciente GPT-4 son dos de las últimas tecnologías en inteligencia artificial que están dando mucho de qué hablar (y seguirá durante muchos años). GPT-3 se lanzó en mayo de 2020 y su sucesor GPT-4 acaba de ver la luz (14 de marzo).

Con la creciente popularidad de ChatGPT, que fue desarrollado por la misma compañía, la pregunta ahora es hasta qué punto OpenAI ha innovado con el modelo de lenguaje GPT-4, cuáles son sus mejoras y si realmente hay grandes avances con respecto a la versión anterior.

Ambos GPT ofrecerán capacidades avanzadas para el procesamiento del lenguaje natural, pero existen algunas diferencias significativas entre los dos.

GPT-4 vs. GPT-3: ¿Cuál es la diferencia?

Más poder en una escala más pequeña

Es importante aquí señalar que OpenAI, tal y como acostumbra, es muy cautelosa a la hora de ofrecer toda la información y los parámetros utilizados en GPT-4 confirman la regla.

Muchos expertos llevan ya tiempo sugiriendo que esta mejora con respecto a GPT-3 no va a venir en forma de aumentar drásticamente los parámetros con los que se ha entrenado el modelo. En este caso más no es igual a mejor. GPT-3 cuenta con 12 capas y 175.000 millones de parámetros y se estima que GPT-4 lo supere pero no con una abismal diferencia.

Con herramientas como ChatGPT, entre otras, ya se ha demostrado que el número de parámetros no lo es todo, sino que la arquitectura, la cantidad de datos y la calidad también desempeñan un papel importante en el entrenamiento. «En el futuro, mucha gente se sorprenderá de lo potente que puede llegar a ser la IA sin que crezcan los parámetros», afirma Sam Altman, CEO de OpenAI.

Naturaleza multimodal

Otra gran diferencia a destacar y ya anunciada por OpenAI es su naturaleza multimodal. En lugar de trabajar únicamente con texto, GPT-4 también será capaz de admitir imágenes como entrada. Es decir, podrás subir imágenes para dar indicaciones de forma visual y que esto acabe transformándose en texto.

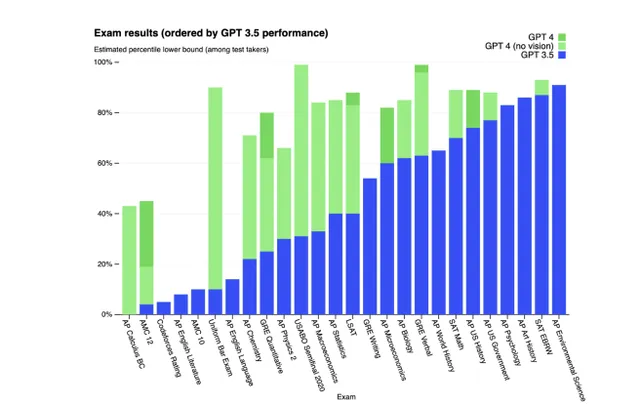

«Hemos creado GPT-4, el último hito en el esfuerzo de OpenAI por ampliar el aprendizaje profundo. GPT-4 es un gran modelo multimodal (que acepta entradas de imágenes y texto, y salidas de texto) que, si bien es menos capaz que los humanos en muchos escenarios del mundo real, exhibe un rendimiento a nivel humano en varios puntos de referencia académicos y profesionales», explica OpenAI en su nota de prensa.

Calidad de la información

Uno de los mayores desafíos que enfrentan los modelos de PNL (Procesamiento Natural del Lenguaje) son los datos de entrenamiento inexactos, lo que en última instancia los hace susceptibles de proporcionar información errónea.

OpenAI emplea algoritmos de RLHF (Aprendizaje por Refuerzo con Retroalimentación Humana) para frenar este problema. Los entrenadores humanos usan este algoritmo para ajustar los modelos impulsados por IA a través de un ajuste fino muy supervisado. En última instancia, esto ayuda a reducir la susceptibilidad del modelo a la información errónea, así como a generar contenido tóxico o sesgado.

Menos alucinaciones

Para contextualizar, las alucinaciones de la IA, en pocas palabras, se basa en ofrecer información falsa pero muy detallada sobre un evento que no ha ocurrido. Es como si la inteligencia artificial se convirtiese en futuróloga cuando su uso debe basarse en hechos reales y contrastados.

Lógicamente y tal y como han explicado grandes compañías como Google o Microsoft, sus chatbots no son exactos y pueden dar lugar a error, pero el hecho de que alucinen y se inventen sucesos que no han ocurrido, va un paso más allá. Parece que esto en GPT-4 ya se está solucionando.

«Pasamos seis meses haciendo que GPT-4 sea más seguro y más alineado. GPT-4 tiene un 82 % menos de probabilidades de responder a solicitudes de contenido no permitido y un 40 % más de probabilidades de producir respuestas fácticas», dijo OpenAI.

El CEO de OpenAI, Sam Altman admitió que, a pesar de la anticipación, GPT-4 «todavía tiene fallas, todavía es limitado y aún parece más impresionante en el primer uso que después de pasar más tiempo con él».

Con información de Computer Hoy